问题一:请问flink oracle cdc 有没有谁编译支持server_name 连接方式的jar?

请问flink oracle cdc 有没有谁编译支持server_name 连接方式的jar?

参考答案:

这个问题在cdc 2.3版本迭代后就可以解决。

关于本问题的更多回答可点击进行查看:

/ask/497096?spm=a2c6h.13066369.question.28.61ee1fbaHo0ENx

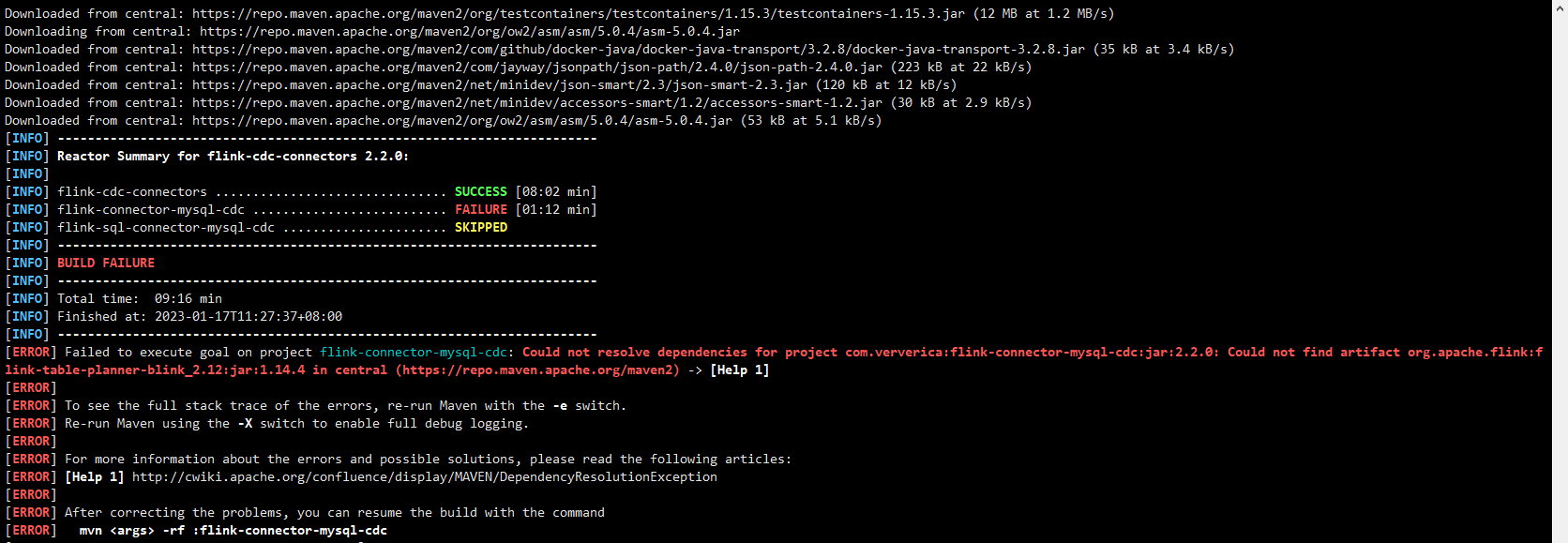

问题二:对于Flink CDC,pom文件(最外层的和这个模块的)明明已经没有blink了,为啥还报错?

对于Flink CDC,pom文件(最外层的和这个模块的)明明已经没有blink了,为啥编译还会爆这个错误呢?

参考答案:

如果您在 Flink CDC 的 pom 文件中没有使用 Blink,但仍然遇到 Blink 相关的错误,则可能是由于以下原因:

依赖关系冲突:您的项目中可能有其他依赖项与 Flink CDC 冲突并引入 Blink 依赖项。

缓存问题:您的本地 Maven 缓存可能仍包含旧版本的 Flink CDC 依赖项,其中包含 Blink。

错误的配置:您可能在 Flink 作业的配置中显式设置了 Blink 依赖项。

关于本问题的更多回答可点击进行查看:

/ask/482468?spm=a2c6h.13066369.question.29.61ee1fbaBblahr

问题三:windows 安装flink的,在页面添加cdc编译包之后,但是看不到变更日志,是怎么回事?

windows 安装flink的,在页面添加cdc编译包之后,但是看不到变更日志,是怎么回事?

参考答案:

这可能是因为你没有正确配置CDC编译包。请确保你已经正确安装了CDC编译包,并且已经在Flink配置文件中添加了CDC编译包的路径。如果你还是看不到变更日志,可以尝试重启Flink服务,以便重新加载CDC编译包。

关于本问题的更多回答可点击进行查看:

/ask/480161?spm=a2c6h.13066369.question.28.61ee1fbahJZ6y2

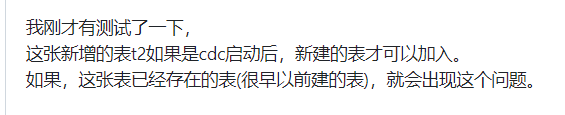

问题四:Flink2.3.0默认的maven依赖,通过checkpoint启动时新增表会报错。类似下面这样。

Flink2.3.0默认的maven依赖,通过checkpoint启动时新增表会报错。类似下面这样。 我找了git上relase-2.3的源码编译后替换jar包,不报错了,但是新增的表不会做全量同步,2.2.1版本好像就没这个问题,flink-cdc-connectors这个项目,有遇到过的大佬指点一下吗

关于本问题的更多回答可点击进行查看:

/ask/503583?spm=a2c6h.13066369.question.31.61ee1fba7aonJJ

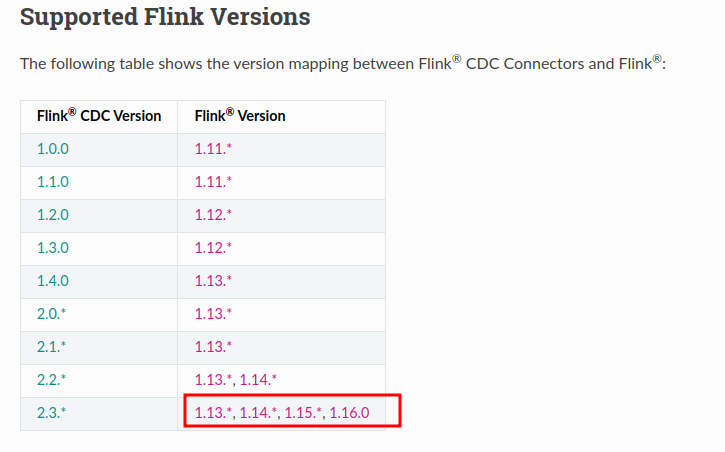

问题五:请教一下以下问题

各位老师,请教下,官方文档上提到cdc 2.3版本兼容 flink 1.14但是看cdc 源码里依赖的是Flink 1.16的版本。改为1.14编译会不通过。想确认下,是这里文档的描述不对,还是我使用方式不对?要怎么使用?

参考答案:

缺依赖。

关于本问题的更多回答可点击进行查看: