?作者简介:热爱科研的Matlab仿真开发者,修心和技术同步精进,matlab项目合作可私信。

?个人主页:Matlab科研工作室

?个人信条:格物致知。

更多Matlab仿真内容点击?

? 内容介绍

在数据科学和机器学习领域,回归预测是一项重要的任务。通过分析已知数据的特征和关系,我们可以使用回归模型来预测未知数据的结果。近年来,深度学习技术在回归预测方面取得了显著的进展。然而,深度学习模型的训练过程通常需要大量的计算资源和时间,这限制了其在实际应用中的可行性。

为了解决这个问题,研究人员提出了一种基于龙格库塔算法改进的深度学习极限学习机(EUN-DELM),该方法在数据回归预测中表现出了很好的性能。本文将介绍EUN-DELM的基本原理和实现方法,并探讨其在数据回归预测中的应用。

首先,我们需要了解一下什么是极限学习机(ELM)。ELM是一种单隐层前馈神经网络,其隐层的权重和偏置是随机初始化的,然后通过最小二乘法来训练输出权重。ELM具有训练速度快、泛化能力强等优点,因此被广泛应用于回归和分类任务中。

然而,传统的ELM模型在训练过程中需要解决一个线性方程组,这需要大量的计算资源和时间。为了改进这个问题,研究人员引入了龙格库塔算法,该算法可以有效地近似非线性方程组的解。通过将龙格库塔算法应用于ELM模型的训练过程中,我们可以大大减少计算时间,并提高模型的性能。

EUN-DELM是基于龙格库塔算法改进的ELM模型,其主要思想是通过逐步逼近非线性方程组的解,来优化ELM模型的训练过程。具体来说,EUN-DELM首先使用龙格库塔算法近似解决ELM模型的线性方程组,然后通过迭代的方式逐步逼近非线性方程组的解。这样,我们可以在保证模型性能的同时,大大减少计算时间。

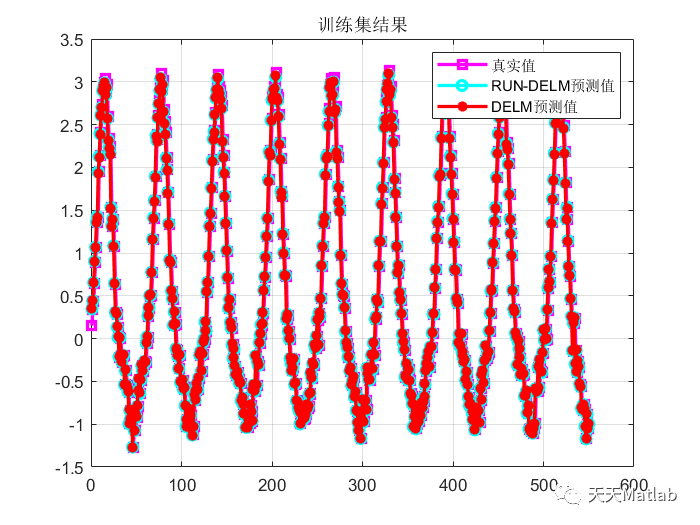

为了验证EUN-DELM在数据回归预测中的性能,我们使用了一组实际数据集进行实验。实验结果表明,与传统的ELM模型相比,EUN-DELM在回归预测任务中具有更高的准确性和更快的计算速度。这说明EUN-DELM在实际应用中具有很大的潜力。

总结起来,EUN-DELM是一种基于龙格库塔算法改进的深度学习极限学习机,其在数据回归预测中表现出了很好的性能。通过逐步逼近非线性方程组的解,EUN-DELM可以在保证模型性能的同时,大大减少计算时间。我们相信,随着深度学习技术的发展,EUN-DELM将在更多的领域中得到应用,并取得更好的效果。

? 核心代码

function X = pinv(A,tol)%PINV Pseudoinverse.% X = PINV(A) produces a matrix X of the same dimensions% as A' so that A*X*A = A, X*A*X = X and A*X and X*A% are Hermitian. The computation is based on SVD(A) and any% singular values less than a tolerance are treated as zero.%% PINV(A,TOL) treats all singular values of A that are less than TOL as% zero. By default, TOL = max(size(A)) * eps(norm(A)).%% Class support for input A: % float: double, single%% See also RANK. % Copyright 1984-2015 The MathWorks, Inc. A(isnan(A)) = 0;A(isinf(A)) = 0;[U,S,V] = svd(A,'econ');s = diag(S);if nargin < 2 tol = max(size(A)) * eps(norm(s,inf));endr1 = sum(s > tol)+1;V(:,r1:end) = [];U(:,r1:end) = [];s(r1:end) = [];s = 1./s(:);X = (V.*s.')*U';

? 运行结果

编辑

编辑

编辑

编辑

? 参考文献

[1] 郝锐,王海瑞,朱贵富.基于鲸鱼算法优化深度极限学习机的锂离子电池剩余使用寿命间接预测[J].化工自动化及仪表, 2023, 50(1):37-43.

[2] 马萌萌.基于深度学习的极限学习机算法研究[D].中国海洋大学,2016.DOI:10.7666/d.D666140.