flink CDC3.0 第一次全量同步Oracle 数据, split chunks 一会就中断

数据表比较大, 有几千万行。

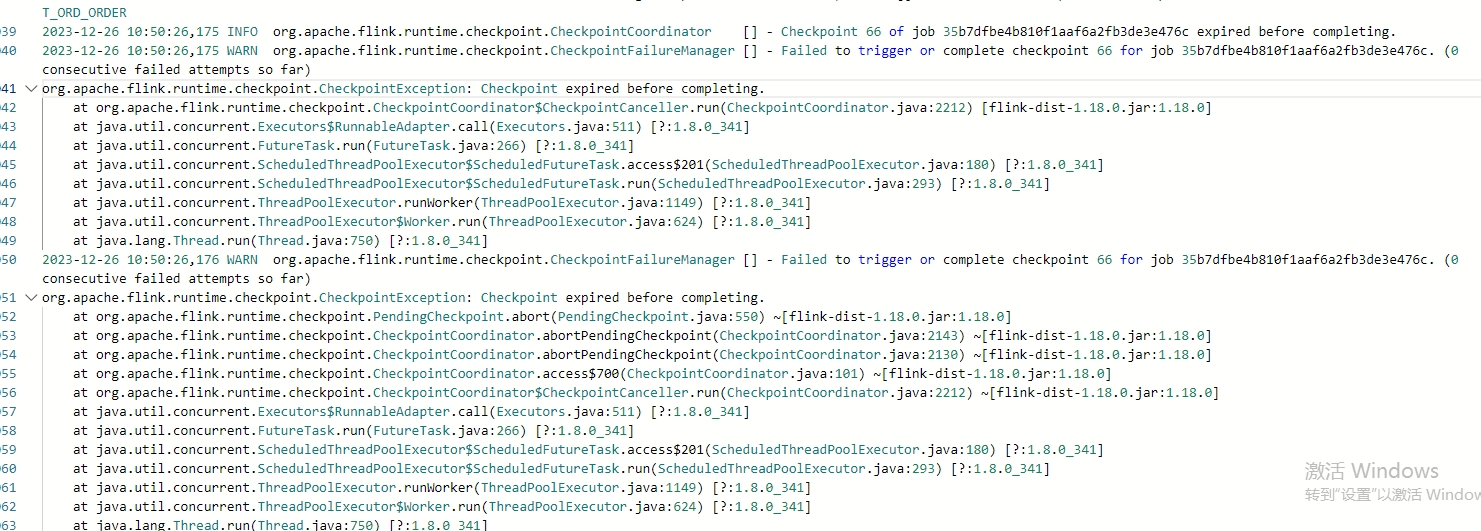

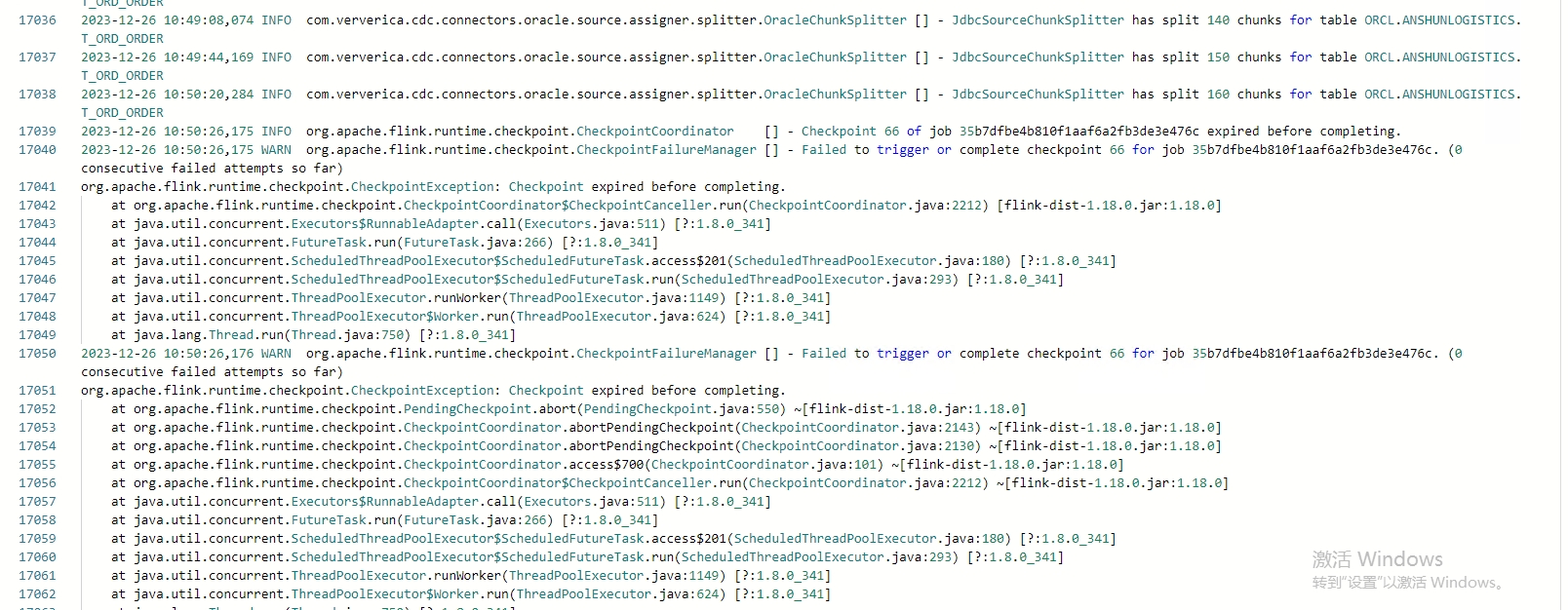

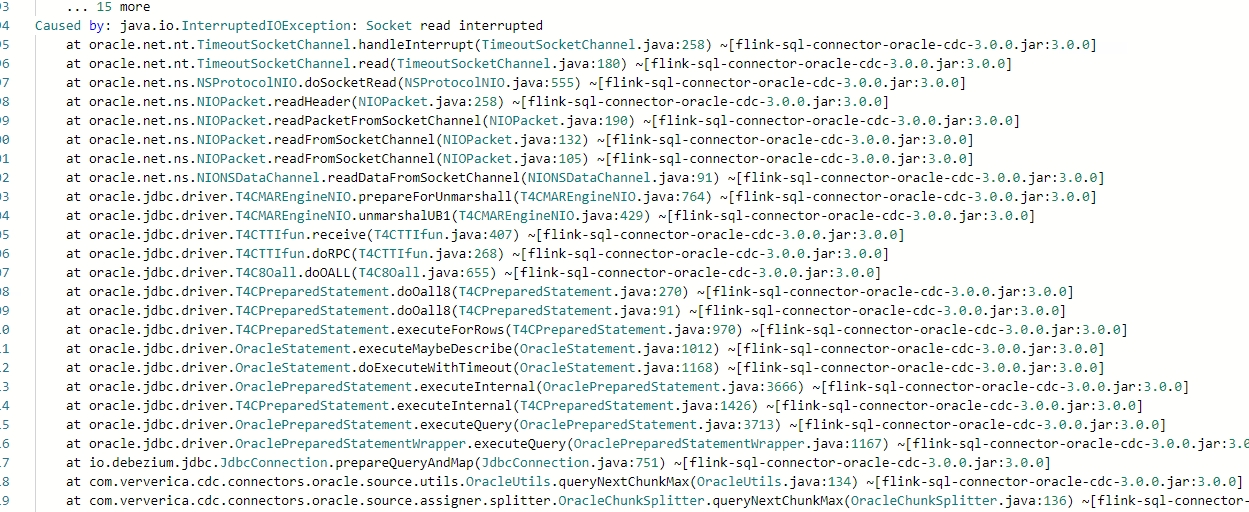

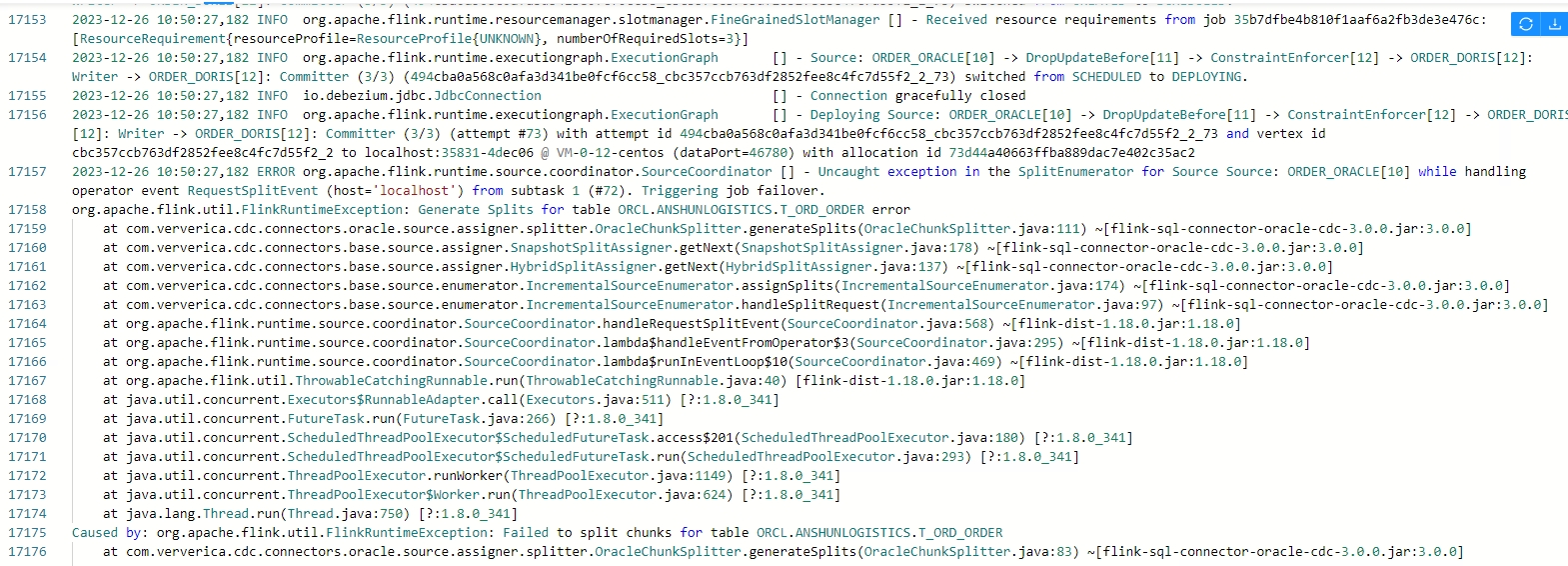

首先提示 :Use unevenly-sized chunks for table ORCL.ANSHUNLOGISTICS.T_ORD_ORDER, the chunk size is 8096

然后执行到10分钟左右,就开始报错。 请专家帮忙看看

展开

收起

1

条回答

写回答

写回答

-

2000元阿里云代金券免费领取,2核4G云服务器仅664元/3年,新老用户都有优惠,立即抢购>>>

这个错误提示"Use unevenly-sized chunks for table ORCL.ANSHUNLOGISTICS.T_ORD_ORDER, the chunk size is 8096"表示你在处理ORCL.ANSHUNLOGISTICS.T_ORD_ORDER这张大数据表时,使用的块大小是8096。对于大数据表,使用均匀大小的块可能会导致内存和性能问题。

然后在执行10分钟左右开始报错,可能是由于以下原因:

内存不足:

- 处理大数据表时,如果内存不足以容纳所有的数据或者中间结果,可能会导致报错。

- 考虑增加可用的系统内存,或者优化你的查询以减少内存使用。

超时问题:

- 如果你的查询或者操作没有设置合适的超时时间,长时间运行的任务可能会被系统中断。

- 检查你的数据库配置,确保设置了合理的查询超时时间和连接超时时间。

锁冲突:

- 在处理大数据表时,如果存在其他的并发操作或者锁冲突,可能会导致报错。

- 确保你的操作不会与其他并发任务产生冲突,或者考虑使用适当的锁定策略来管理并发。

索引问题:

- 如果你的表缺少有效的索引,或者索引没有正确地用于你的查询,可能会导致全表扫描和性能问题。

- 检查你的表结构和索引设计,确保你的查询能够有效地利用索引。

硬件限制:

- 处理大数据表可能需要大量的磁盘I/O和CPU资源。

- 确保你的硬件设备(如磁盘、CPU)能够满足处理大数据表的需求。

为了解决这个问题,你可以尝试以下步骤:

- 增加系统内存或者优化查询以减少内存使用。

- 设置合理的查询和连接超时时间。

- 管理并发操作和锁冲突。

- 检查和优化表结构和索引设计。

- 确保硬件设备能够满足处理大数据表的需求。

同时,你也可以考虑使用一些大数据处理工具或者技术,如分区表、并行查询、外部排序等,来更有效地处理大数据表。

2023-12-29 17:14:31赞同 展开评论 打赏

问答分类:

相关产品:

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

相关问答

热门讨论

热门文章

DSW在机器学习平台PAI产品架构中的位置是怎样的?

2482

数据服务报429请求次数过多咋办呀

1387

flink的1cu是指1cpu还是1cpu+4g存储?

228

为什么 PAI DSW中一直无法使用GPU加速tensorflow,如何使用GPU加速.

57

多个子表单汇总到一个子表单中

168

DataWorks我该如何访问A项目安装了项目的package资源?

673

实验中 Elasticsearch、es kibana login 的默认用户和口令是什么?

1550

宜搭报表,柱线混合图如何实现:收入水平30万以上人数的折线图?

51

使用websocket请求asr 返回40000002错误码

49

幻兽帕鲁服务器搭建

1476

展开全部

阿里巴巴飞天大数据平台MaxCompute(原名ODPS)全套攻略(持续更新20200109)

131555

DeepRec Extension 打造稳定高效的分布式训练

76325

阿里云开源离线同步工具DataX3.0介绍

103138

【技术解析 | 实践】部署Kubernetes模式的Havenask集群

59150

【技术解析 | 实践】Havenask问题排查

52291

【技术解析 | 实践】Havenask文本索引

41425

odps是什么?

67890

拍立淘-以图搜图中的图像搜索算法

36128

【技术实验】mysql准实时同步数据到Elasticsearch

24077

数据仓库介绍与实时数仓案例

40321

展开全部