问题一:DataWorks这种报错是啥原因 源表和目标表是同构的?

DataWorks这种报错是啥原因 源表和目标表是同构的? ... 8 more

2023-11-02 16:13:25.863 [72432510-0-1-writer] ERROR StdoutPluginCollector -

java.sql.SQLException: Incorrect string value: '\xF0\x9F\xA6\x9B' for column 'goods_specifications' at row 1

a

参考回答:

表情符,报错现象: 如果数据中包括表情符,在同步过程中可能会报错脏数据:[13350975-0-0-writer] ERROR StdoutPluginCollector - 脏数据 {"exception":"Incorrect string value: '\xF0\x9F\x98\x82\xE8\xA2...' for column 'introduction' at row 1","record":[{"byteSize":8,"index":0,"rawData":9642,"type":"LONG"},}],"type":"writer"} 。可能原因:数据库相关编码未设置为utf8mb4,导致同步表情符报错。源端的数据本身就是乱码。数据库和客户端的编码不一样。浏览器编码不一样,导致预览失败或乱码。解决方案: 针对产生乱码的不同原因,选择相应的解决方法:如果您的原始数据乱码,需首先处理好原始数据,再进行同步任务。数据库和客户端编码格式不一致,需先修改编码格式。浏览器编码和数据库或客户端编码格式不一致,需先统一编码格式,然后进行数据预览。您可以尝试以下操作:JDBC格式添加的数据源修改utf8mb4:jdbc:mysql://xxx.x.x.x:3306/database?com.mysql.jdbc.faultInjection.serverCharsetIndex=45。

实例ID形式添加数据源:在数据库名后拼接,格式为database?com.mysql.jdbc.faultInjection.serverCharsetIndex=45。修改数据库相关的编码格式为utf8mb4。例如,在RDS控制台修改RDS的数据库编码格式。说明 设置RDS数据源编码格式命令:set names utf8mb4。查看RDS数据库编码格式命令:

show variables like 'char%'。

https://help.aliyun.com/document_detail/146663.html

关于本问题的更多回答可点击原文查看:/ask/567725

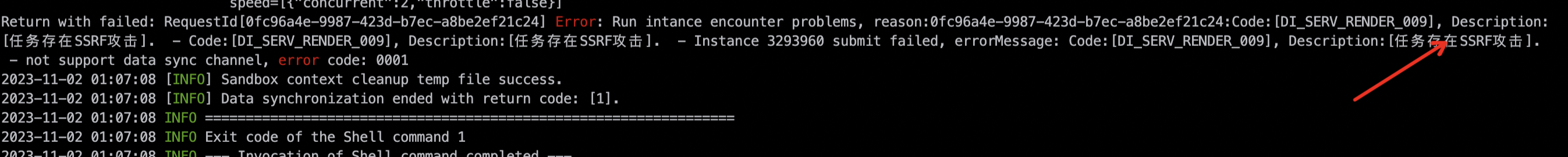

问题二:DataWorks这啥意思?

DataWorks这啥意思?

参考回答:

首先,我们需要理解SSRF(Server Side Request Forgery)攻击是什么。SSRF是一种攻击手段,攻击者通过构造恶意请求,诱使服务器从内部网络或本地发起请求,从而攻击外部或内部的其它服务。

在这个问题中,出现的错误提示 [DI_SERV_RENDER_009] 和 Description:[任务存在SSRF攻击] 表明,你的任务存在SSRF攻击的风险。这可能是因为你的任务在执行过程中,可能会产生对内部或外部网络的请求,而这些请求可能被恶意利用。

解决这个问题,你需要检查你的任务代码,确保在所有的网络请求中,只能对可信任的、公开的、安全的服务器发出请求。任何对内部网络或本地网络的请求都应被严格限制,或者使用特定的、安全的通道。

错误信息 not support data sync channel, error code:0001 表明,你的任务试图使用一个不支持的数据同步通道。你可能需要检查你的任务配置,确保你正在使用正确的、支持的数据同步通道。

关于本问题的更多回答可点击原文查看:/ask/567720

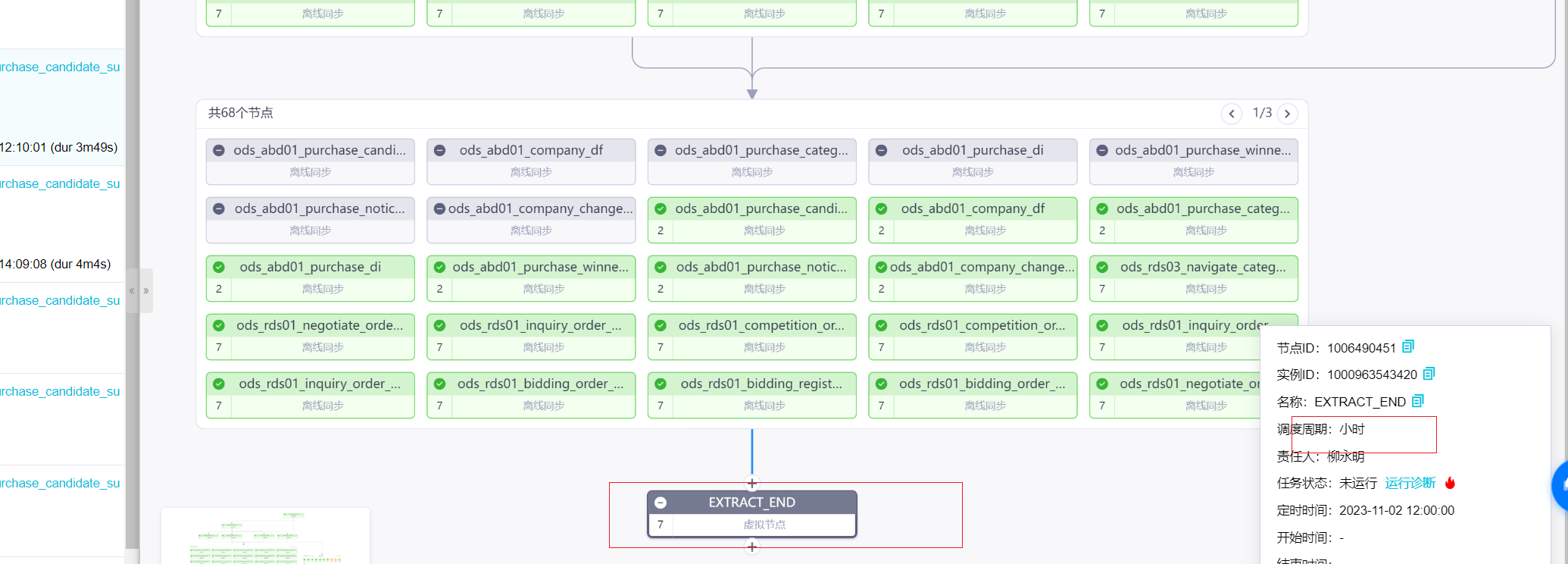

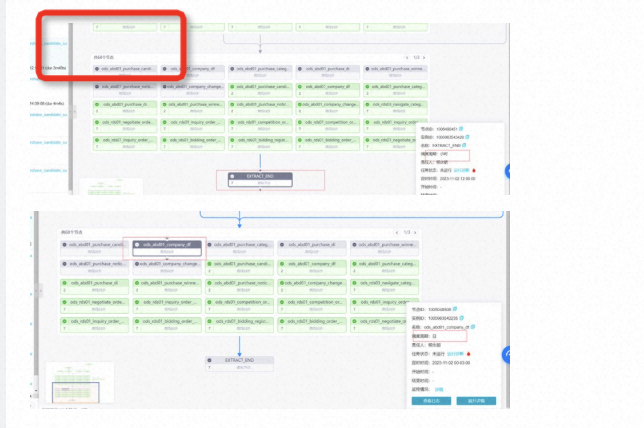

问题三:DataWorks这个就是相当于小时任务依赖天任务,天任务依赖小时任务,但是又没看到触发的按钮?

DataWorks这个就是相当于小时任务依赖天任务,天任务依赖小时任务,导致天任务后面的小时任务一直没运行,我现在想怎么样把这个天任务让他运行起来,但是又没看到触发的按钮?没有成环,就是我现在想让这个下游的小时任务运行起来,但是这就需要让这个上游的天任务运行,天任务又需要等待上游当天所有的小时任务,我想现在有啥方法直接让这个天任务运行起来吗?

参考回答:

任务成环了吗? 正常情况下是个有向无环图 通过上游分析可以快速定位到失败的位置 ,运行不起来是因为上游失败了,直接运行不起来 除非强制去掉依赖 ;需要找到上游失败的实例 置为成功,依赖至少保留一个,实例右键 可以强制去除依赖

关于本问题的更多回答可点击原文查看:/ask/567717

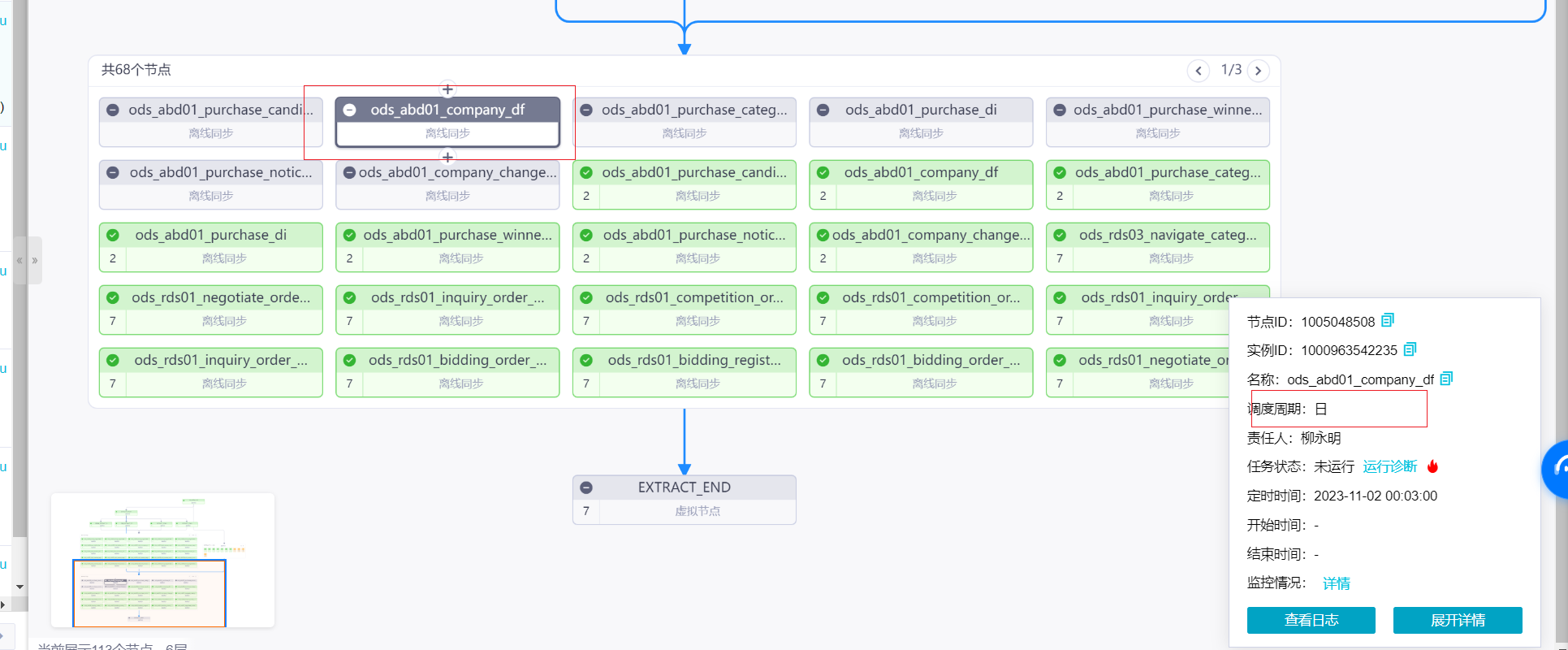

问题四:DataWorks这种小时任务依赖天任务,让下面这个小时任务快速运行呢?

DataWorks这种小时任务依赖天任务,是我没有把上面的天任务修改过来,这种如何触发上面这个天任务,让下面这个小时任务快速运行呢?

参考回答:

左上角有个上游分析 可以定位看下最先开始失败 导致下游不运行的实例是哪个 需要先解决那个问题 业务数据通过补数据解决 然后失败实例置为成功 下游会自动运行

关于本问题的更多回答可点击原文查看:/ask/567713

问题五:DataWorks使用数据集成整库全增量同步oceanbase数据到odps的时候,帮忙看下呢?

DataWorks使用数据集成整库全增量同步oceanbase数据到odps的时候,同步全量数据报错了,帮忙看下呢?

参考回答:

根据您提供的错误日志,问题出在全量数据同步到ODPS时出现了状态冲突错误。具体来说,是在提交上传块时出现了问题。为了解决这个问题,您可以尝试以下方法:

- 检查您的OceanBase数据库和ODPS表的连接配置是否正确,包括用户名、密码、主机名、端口号等。

- 确保您的OceanBase数据库中的数据已经完整备份,并且没有损坏或丢失。

- 检查您的DataWorks任务配置,确保全量同步的参数设置正确,例如源表和目标表的名称、分批大小等。

关于本问题的更多回答可点击原文查看:/ask/567660